«`html

Преимущества ИИ и Многофункциональные Модели

Развитие ИИ привело к созданию многофункциональных моделей, которые одновременно обрабатывают текст, изображения и речь. Эти модели могут изменить различные приложения, от создания контента до перевода, так как они позволяют генерировать и интерпретировать сложные данные.

Проблемы и Решения

Однако для достижения этих целей требуются огромные вычислительные ресурсы, что создает барьеры для масштабирования и эффективности. Традиционные языковые модели оптимизированы для текста, и их расширение для обработки изображений и аудио требует значительных вычислительных мощностей.

Стратегии для Эффективности

Существуют различные стратегии для повышения вычислительной эффективности многофункциональных моделей. Одним из подходов является использование разреженных архитектур, таких как Mixture-of-Experts (MoE), которые активируют только определенные части модели по мере необходимости.

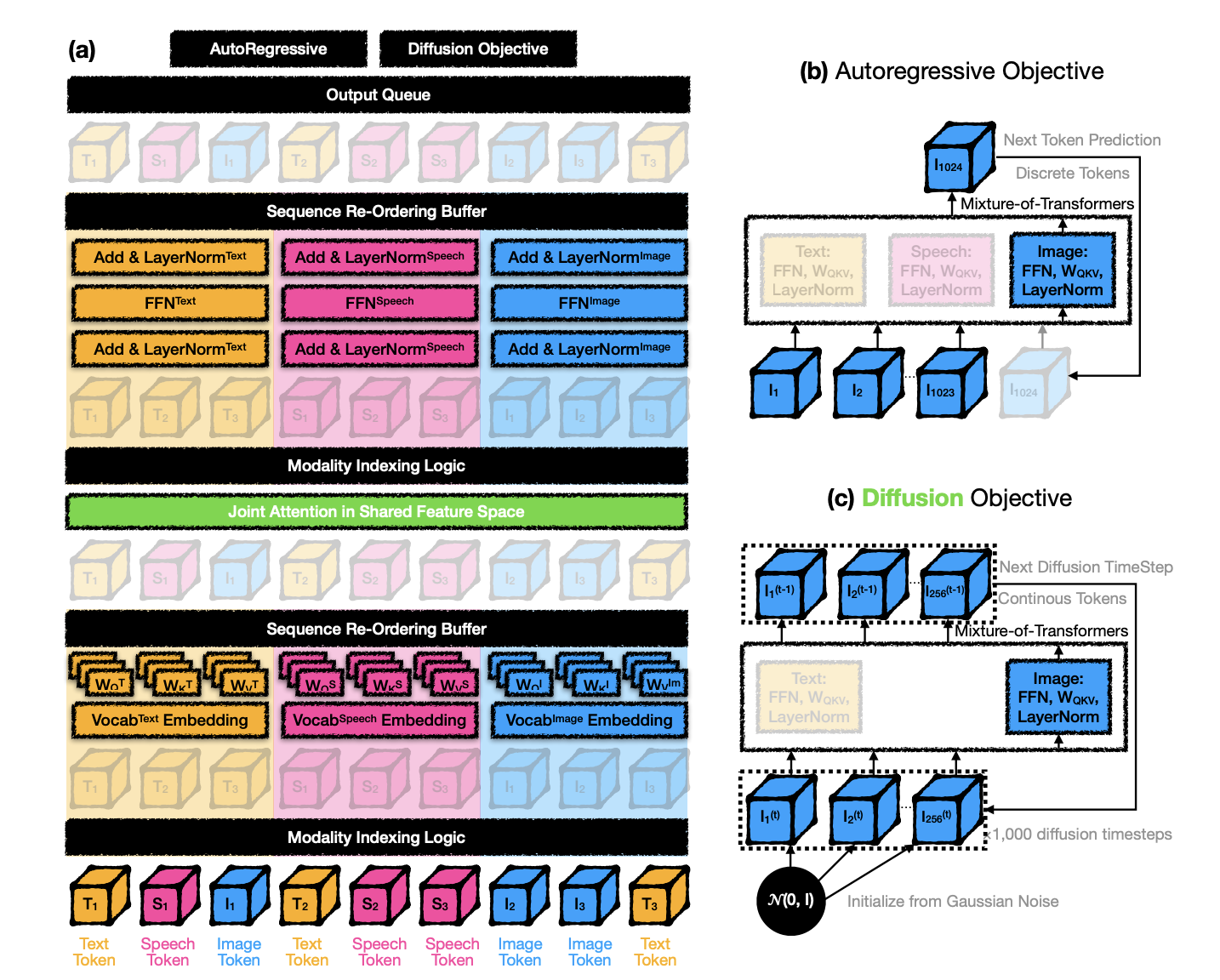

Новая Архитектура: Mixture-of-Transformers (MoT)

Исследователи Meta и Стэнфордского университета представили новую архитектуру под названием Mixture-of-Transformers (MoT). MoT снижает вычислительные требования, используя параметры, специфичные для каждой модальности, что позволяет оптимизировать обработку без дополнительных компонентов модели.

Преимущества MoT

- Эффективная Многофункциональная Обработка: MoT достигает результатов с использованием 37.2% до 55.8% вычислительных ресурсов по сравнению с плотными моделями.

- Ускорение Обучения: MoT сократил время обучения для задач изображений на 52.8% и для текстовых задач на 24.4% при сохранении точности.

- Адаптивная Масштабируемость: MoT эффективно обрабатывает дискретные и непрерывные токены для нескольких модальностей без дополнительных слоев обработки.

- Снижение Ресурсов в Реальном Времени: MoT значительно сократил время обучения, что делает его подходящим для приложений в реальном времени.

Заключение

Mixture-of-Transformers предлагает инновационный подход к многофункциональному моделированию, обеспечивая эффективное и масштабируемое решение для интеграции различных типов данных в единую структуру. Это прорыв может изменить ландшафт ИИ, позволяя создавать более доступные и ресурсосберегающие модели для сложных многофункциональных приложений.

Как Внедрить ИИ в Ваш Бизнес

Если вы хотите, чтобы ваша компания развивалась с помощью ИИ, следуйте этим шагам:

- Проанализируйте, как ИИ может изменить вашу работу.

- Определите ключевые показатели эффективности (KPI), которые хотите улучшить с помощью ИИ.

- Подберите подходящее решение, начните с малого проекта и анализируйте результаты.

- Расширяйте автоматизацию на основе полученных данных и опыта.

Получите Поддержку

Если вам нужны советы по внедрению ИИ, пишите нам. Следите за новостями об ИИ в нашем Телеграм-канале.

Попробуйте AI Sales Bot

Это AI ассистент для продаж, который помогает отвечать на вопросы клиентов и генерировать контент для отдела продаж.

«`