«`html

Релиз Pharia-1-LLM-7B: Две различные варианты — Pharia-1-LLM-7B-Control и Pharia-1-LLM-7B-Control-Aligned от исследователей Aleph Alpha

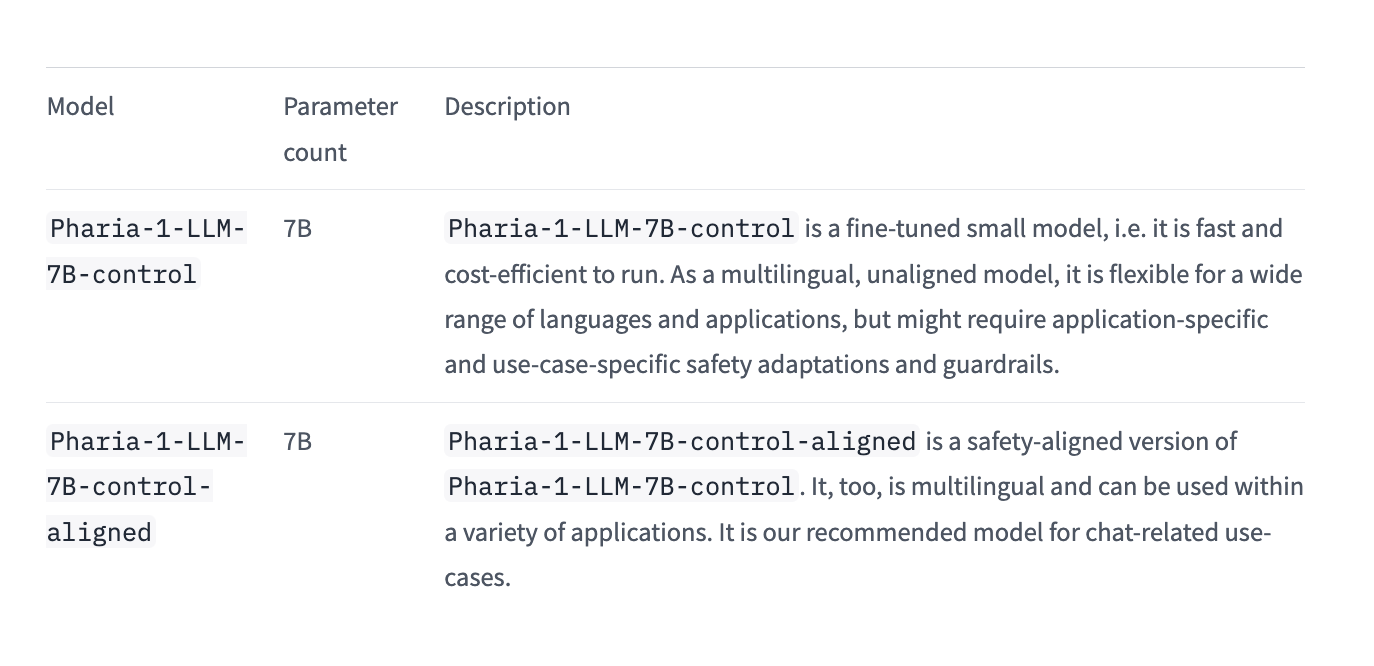

Исследователи из Aleph Alpha объявляют о выпуске новой семьи базовых моделей, включающей Pharia-1-LLM-7B-control и Pharia-1-LLM-7B-control-aligned. Эти модели теперь доступны для общественного использования в соответствии с лицензией Open Aleph, позволяющей использование в некоммерческих исследованиях и образовательных целях. Этот релиз представляет собой значительный шаг в обеспечении доступности высокопроизводительных языковых моделей для сообщества.

Особенности модели Pharia-1-LLM-7B-control:

Модель разработана для предоставления кратких, контролируемых по длине ответов, соответствующих производительности ведущих моделей с открытым исходным кодом в диапазоне параметров от 7B до 8B. Модель культурно и лингвистически оптимизирована для немецкого, французского и испанского благодаря обучению на мультиязычном корпусе. Эта особенность повышает ее универсальность в различных языковых контекстах.

Обучающие данные модели:

Тщательно отобраны в соответствии с применимыми законодательством ЕС и национальными нормативными актами, включая законы об авторском праве и конфиденциальности данных. Это внимание к юридическим и этическим аспектам обеспечивает возможность уверенного использования модели Pharia-1-LLM-7B-control в различных исследовательских и образовательных средах.

Применение в конкретных отраслях:

Модель прекрасно подходит для областно-специфических приложений, особенно в автомобильной и инженерной отраслях. Ее возможность быть адаптированной к предпочтениям пользователя делает ее подходящей для критических приложений без риска поведения выключения, что решает распространенную проблему внедрения ИИ.

Второй вариант модели Pharia-1-LLM-7B-control-aligned:

Улучшен дополнительными системами безопасности, используя методы выравнивания. Этот вариант предлагает дополнительный уровень безопасности и надежности, что делает его идеальным для приложений, где безопасность и контролируемый вывод играют решающую роль.

Сопровождающие релизу ресурсы включают подробную карточку модели и подробный блог-пост.

Оптимизация гиперпараметров:

Исследователи планировали оптимизировать гиперпараметры, используя небольшую модель-прокси с размером скрытого слоя 256 и 27 слоями, соответствующими количеству слоев целевой модели. Данный метод был успешно применен для поиска гиперпараметров для моделей размером 1B, с переходом к 7B вызывающим нестабильность обучения. В дальнейшем был разработан улучшенный подход к применению этого метода, что привело к публикации статьи с модифицированной, численно стабильной версией.

Обучение модели:

Были применены эффективные стратегии обучения, включая использование формата bfloat16 с миксированием точности и использование параллельных вычислений для оптимизации процесса. Обучение модели охватило общий объем токенов в 7.7T, что позволило получить высокую производительность.

Рекомендации по применению моделей:

Pharia-1-LLM-7B-control-aligned и Pharia-1-LLM-7B-control предлагают улучшенные возможности для различных исследовательских и прикладных потребностей в области ИИ.

«`