Исследование приобретения и сохранения фактических знаний в больших языковых моделях

Проблема забывания и плохой обобщаемости в LLM

Большие языковые модели (LLM) имеют сложности с сохранением фактических знаний из-за больших объемов данных. Это влияет на их способность обобщать информацию, что затрудняет их применение в различных областях.

Методы оптимизации для улучшения сохранения знаний

Для решения этой проблемы предлагается увеличивать размер моделей и наборы данных, использовать оптимизацию и изменять размер пакетов данных. Также предлагается удаление дубликатов данных для эффективного обучения.

Новаторский подход к обучению LLM

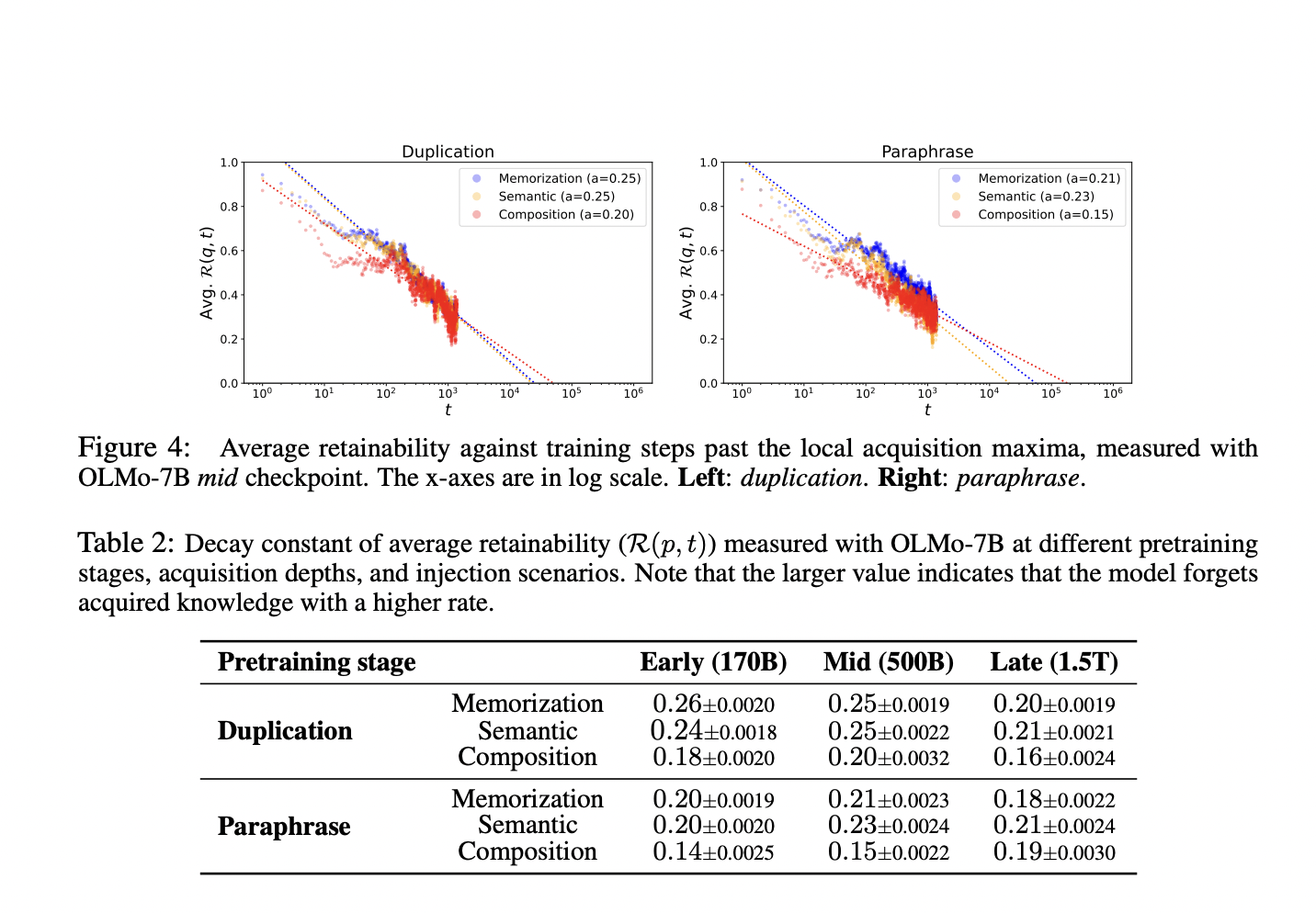

Исследователи из KAIST, UCL и KT предложили эксперимент, в ходе которого модели систематически вводились новые фактические знания. Это позволило оптимизировать стратегии обучения для улучшения долговременной памяти в LLM.

Выводы и практические рекомендации

Исследование показало, что увеличение размера моделей и использование качественных данных способствуют лучшему сохранению фактических знаний. Оптимизация размера пакетов данных также играет важную роль в улучшении производительности LLM.