«`html

Retrieval Augmented Generation (RAG) — Улучшение возможностей LLM с помощью интеграции системы поиска документов

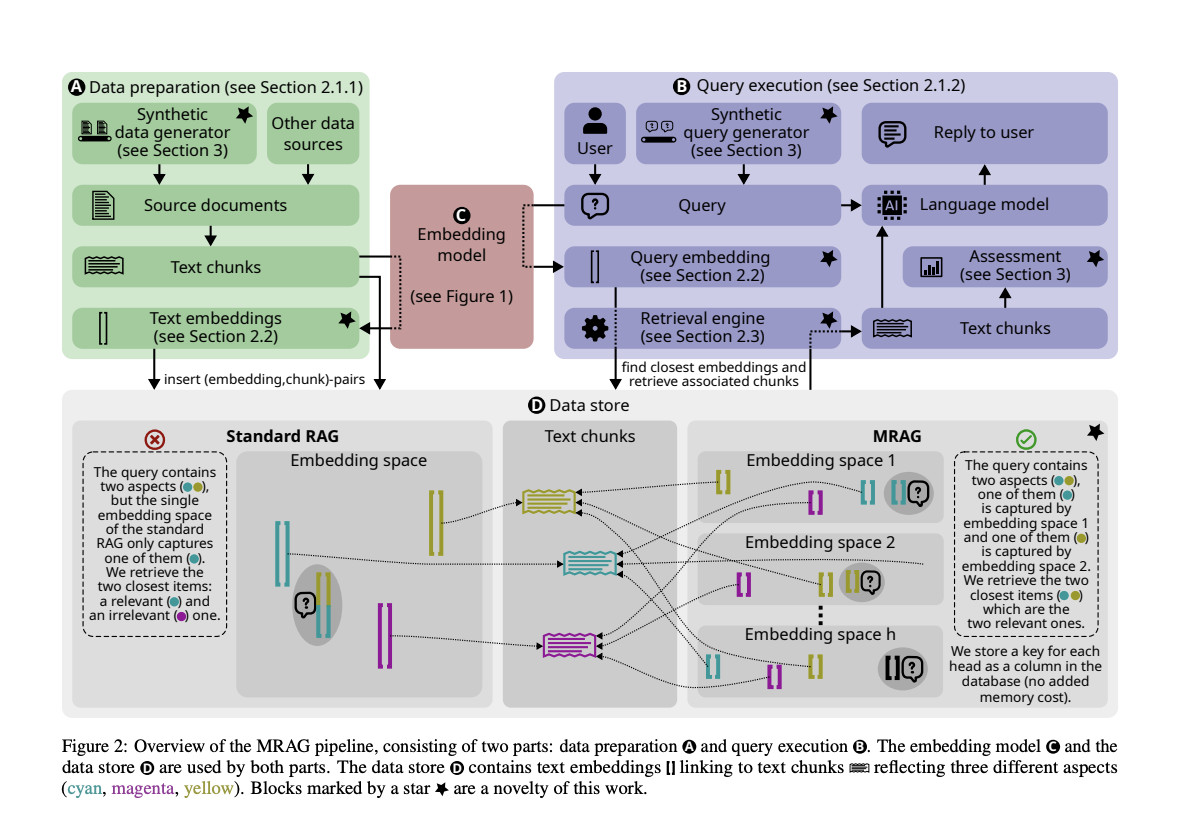

Метод Retrieval Augmented Generation (RAG) улучшает возможности Large Language Models (LLMs) путем интеграции системы поиска документов. Это позволяет LLM извлекать соответствующую информацию из внешних источников, улучшая точность и актуальность генерируемых ответов. Этот подход решает ограничения традиционных LLM, такие как необходимость обширного обучения и риск предоставления устаревшей или некорректной информации. Основное преимущество RAG заключается в его способности привязывать выводы модели к надежным источникам, тем самым снижая галлюцинации и обеспечивая актуальные знания без необходимости дорогостоящего постоянного обучения.

Проблема множественных запросов в RAG

Одной из значительных проблем в RAG является обработка запросов, требующих нескольких документов с разнообразным содержанием. Такие запросы встречаются в различных отраслях, но представляют сложность из-за того, что необходимые документы могут иметь существенно различные вложения, что затрудняет точное извлечение всей соответствующей информации. Эта проблема требует решения, которое может эффективно извлекать и объединять информацию из нескольких источников.

Решение в виде Multi-Head RAG (MRAG)

Исследователи из ETH Zurich, Cledar, BASF SE и Warsaw University of Technology представили Multi-Head RAG (MRAG) для решения проблемы множественных запросов. Эта новая схема использует активации из многочисленных головок внимания слоя Transformer моделей вместо активаций последнего слоя декодера. MRAG создан для использования различных головок внимания для захвата различных аспектов данных, улучшая точность извлечения для сложных запросов.

Практические преимущества MRAG

MRAG значительно улучшает актуальность извлечения, показывая до 20% лучшую производительность по сравнению с базовыми показателями RAG при извлечении многогранных документов. Оценка использовала синтетические наборы данных и реальные кейсы, доказывая эффективность MRAG в различных сценариях.

Применение MRAG в реальных задачах

Кроме улучшения актуальности извлечения, MRAG является экономически эффективным и энергоэффективным методом, не требующим дополнительных запросов LLM, увеличенного хранилища или множественных проходов модели. Эта эффективность, в сочетании с улучшенной точностью извлечения, позиционирует MRAG как ценное достижение в области LLM и систем RAG.

Выводы

Внедрение MRAG является значительным прорывом в области RAG, решая проблемы, возникающие при многогранных запросах. Путем использования механизма многоголового внимания моделей Transformer, MRAG предлагает более точное и эффективное решение для сложных потребностей в извлечении документов.

Посмотреть статью. Все заслуги за это исследование принадлежат исследователям этого проекта. Также не забудьте подписаться на наш Twitter. Присоединяйтесь к нашему Telegram-каналу, Discord-каналу и группе в LinkedIn.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему 44k+ ML SubReddit

Попробуйте AI Sales Bot здесь. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж и снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab здесь. Будущее уже здесь!

«`