«`html

Language Models (LMs) and Machine Unlearning

Языковые модели (LM) сталкиваются с серьезными проблемами, связанными с конфиденциальностью и авторскими правами из-за обучения на огромных объемах текстовых данных. Включение частной и защищенной авторским правом информации в обучающие наборы данных привело к юридическим и этическим проблемам, включая судебные иски по авторским правам и требования соответствия регулятивным актам, таким как GDPR. Владельцы данных все чаще требуют удаления своих данных из обученных моделей, что подчеркивает необходимость эффективных методов машинного «забывания». Эти разработки побудили исследования методов, которые могут преобразовать существующие обученные модели так, чтобы они вели себя так, будто никогда не сталкивались с определенными данными, сохраняя при этом общую производительность и эффективность.

Практические решения и ценность

Исследователи предприняли различные попытки решить проблемы машинного «забывания» в языковых моделях. Точные методы «забывания», которые стремятся сделать «забытую» модель идентичной модели, переобученной без забытых данных, были разработаны для простых моделей, таких как SVM и наивные байесовские классификаторы. Однако эти подходы вычислительно невозможны для современных больших языковых моделей.

Появились приблизительные методы «забывания» как более практичные альтернативы. Они включают методы оптимизации параметров, такие как градиентный подъем, метод «забывания» с учетом локализации, направленный на конкретные модельные блоки, и метод «забывания» в контексте, который изменяет выводы модели с использованием внешних знаний. Исследователи также изучили применение «забывания» к конкретным вспомогательным задачам и для устранения вредных поведенческих моделей языковых моделей.

Методы оценки машинного «забывания» в языковых моделях в основном сосредоточены на конкретных задачах, таких как ответы на вопросы или завершение предложений. Метрики, такие как оценки знакомства и сравнения с переобученными моделями, использовались для оценки эффективности «забывания». Однако существующие оценки часто не обладают всесторонностью и не уделяют должного внимания реальным аспектам развертывания, таким как масштабируемость и последовательные запросы на «забывание».

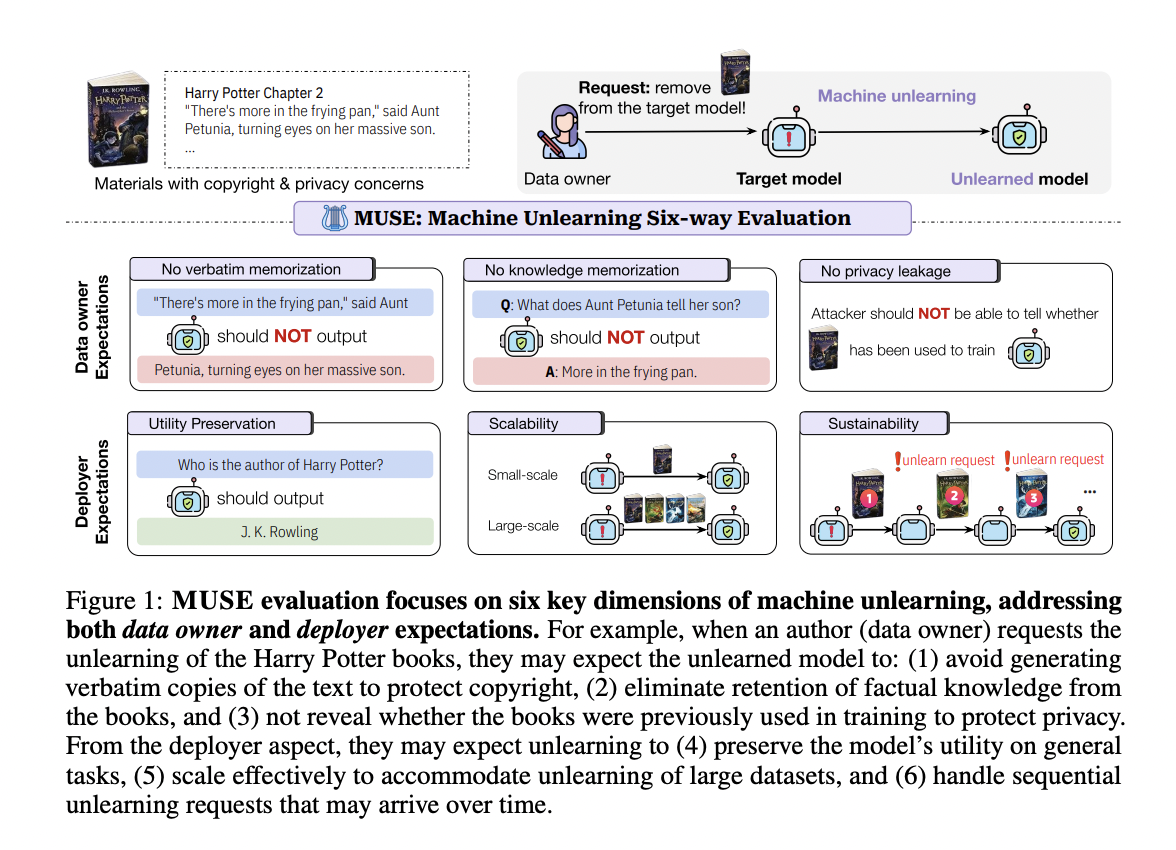

Исследователи из Университета Вашингтона, Принстонского университета, Университета Южной Калифорнии, Чикагского университета и Google Research представляют MUSE (Machine Unlearning Six-Way Evaluation) — комплексную систему, разработанную для оценки эффективности алгоритмов машинного «забывания» для языковых моделей. Этот систематический подход оценивает шесть критических свойств, которые удовлетворяют требованиям как владельцев данных, так и развертывающих модели, для практичного «забывания». MUSE исследует способность алгоритмов «забывания» удалять дословное запоминание, запоминание знаний и утечку конфиденциальной информации, а также оценивает их способность сохранять полезность, эффективно масштабироваться и поддерживать производительность при множественных запросах на «забывание». Применяя эту систему для оценки восьми представительных алгоритмов машинного «забывания» на наборах данных, сфокусированных на «забывании» книг о Гарри Поттере и новостных статьях, MUSE предоставляет всестороннее представление о текущем состоянии и ограничениях техник «забывания» в реальных сценариях.

Оценка MUSE и Результаты

MUSE предлагает комплексный набор метрик оценки, удовлетворяющих ожиданиям как владельцев данных, так и развертывающих модель, для машинного «забывания» в языковых моделях. Система состоит из шести ключевых критериев:

Ожидания владельцев данных:

- Отсутствие дословного запоминания: Измеряется путем подачи модели начала последовательности из набора «забытых» данных и сравнения продолжения модели с истинным продолжением с использованием метрики ROUGE-L F1.

- Отсутствие запоминания знаний: Оценивается путем тестирования способности модели отвечать на вопросы, происходящие из набора «забытых» данных, с использованием метрик ROUGE для сравнения сгенерированных моделью ответов с истинными ответами.

- Отсутствие утечки конфиденциальной информации: Оценивается с использованием метода атаки на определение членства (MIA) для обнаружения, сохраняет ли модель информацию, указывающую на то, что набор «забытых» данных был частью обучающих данных.

Ожидания развертывающих модель:

- Сохранение полезности: Измеряется путем оценки производительности модели на наборе «сохраненных» данных с использованием метрики запоминания знаний.

- Масштабируемость: Оценивается путем изучения производительности модели на наборах «забытых» данных различного размера.

- Устойчивость: Анализируется путем отслеживания производительности модели при последовательных запросах на «забывание».

MUSE оценивает эти метрики на двух представительных наборах данных: NEWS (новостные статьи BBC) и BOOKS (серия о Гарри Поттере), предоставляя реалистичную площадку для оценки алгоритмов «забывания» в практических сценариях.

Оценка MUSE восьми методов «забывания» выявила значительные проблемы в машинном «забывании» для языковых моделей. В то время как большинство методов эффективно удаляли дословное и знаниевое запоминание, они сталкивались с утечкой конфиденциальной информации, часто недостаточно или избыточно «забывая». Все методы значительно ухудшали полезность модели, приводя к невозможности использования некоторых из них. Проблемы масштабируемости возникали с увеличением размеров наборов «забытых» данных, а устойчивость оказалась проблематичной при последовательных запросах на «забывание», что приводило к постепенному ухудшению производительности. Эти результаты подчеркивают значительные компромиссы и ограничения в текущих методиках «забывания», подчеркивая настоятельную необходимость в более эффективных и сбалансированных подходах, удовлетворяющих требованиям как владельцев данных, так и развертывающих модель.

Это исследование представляет MUSE, комплексную систему оценки машинного «забывания», оценивающую шесть ключевых свойств, критических как для владельцев данных, так и для развертывающих модель. Оценка показывает, что в настоящее время методы «забывания» эффективно предотвращают запоминание контента, но делают это за существенную цену для полезности модели на сохраненных данных. Кроме того, эти методы часто приводят к значительной утечке конфиденциальной информации и испытывают трудности с масштабируемостью и устойчивостью при обработке удаления контента большого масштаба или последовательных запросов на «забывание». Эти результаты подчеркивают ограничения существующих подходов и подчеркивают настоятельную необходимость в разработке более надежных и сбалансированных методов машинного «забывания», способных лучше удовлетворять сложные требования реальных приложений.

Применение Искусственного Интеллекта (ИИ) в Маркетинге и Продажах

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте MUSE: A Comprehensive AI Framework for Evaluating Machine Unlearning in Language Models.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru. Будущее уже здесь!

«`