«`html

Институт искусственного интеллекта AI2 представил новый набор активов OLMo 1B и 7B

Институт искусственного интеллекта AI2 сделал значительный шаг в развитии открытых языковых моделей с запуском OLMo (Open Language Model). Этот фреймворк предоставляет исследователям и академикам полный доступ к данным, коду обучения, моделям и инструментам оценки, способствуя совместным исследованиям в области искусственного интеллекта. Первоначальный релиз включает несколько вариантов моделей с 7 миллиардами параметров и модель с 1 миллиардом параметров, обученных как минимум на 2 трлн токенов.

Практические решения и ценность:

OLMo предназначен для развития исследований в области искусственного интеллекта, позволяя исследовать влияние конкретных подмножеств данных предварительного обучения на результативность и изучать новые методы предварительного обучения. Этот открытый подход способствует более глубокому пониманию языковых моделей и их потенциальных нестабильностей, способствуя коллективному развитию науки об искусственном интеллекте.

Каждая модель OLMo поставляется с набором ресурсов, включая полные данные обучения, веса моделей, код обучения, журналы и метрики. Фреймворк также предоставляет более 500 контрольных точек для каждой базовой модели, адаптированные версии модели 7B (OLMo-7B-Instruct и OLMo-7B-SFT), код оценки и возможности тонкой настройки. Все компоненты выпущены под лицензией Apache 2.0, обеспечивая широкий доступ для исследовательского сообщества.

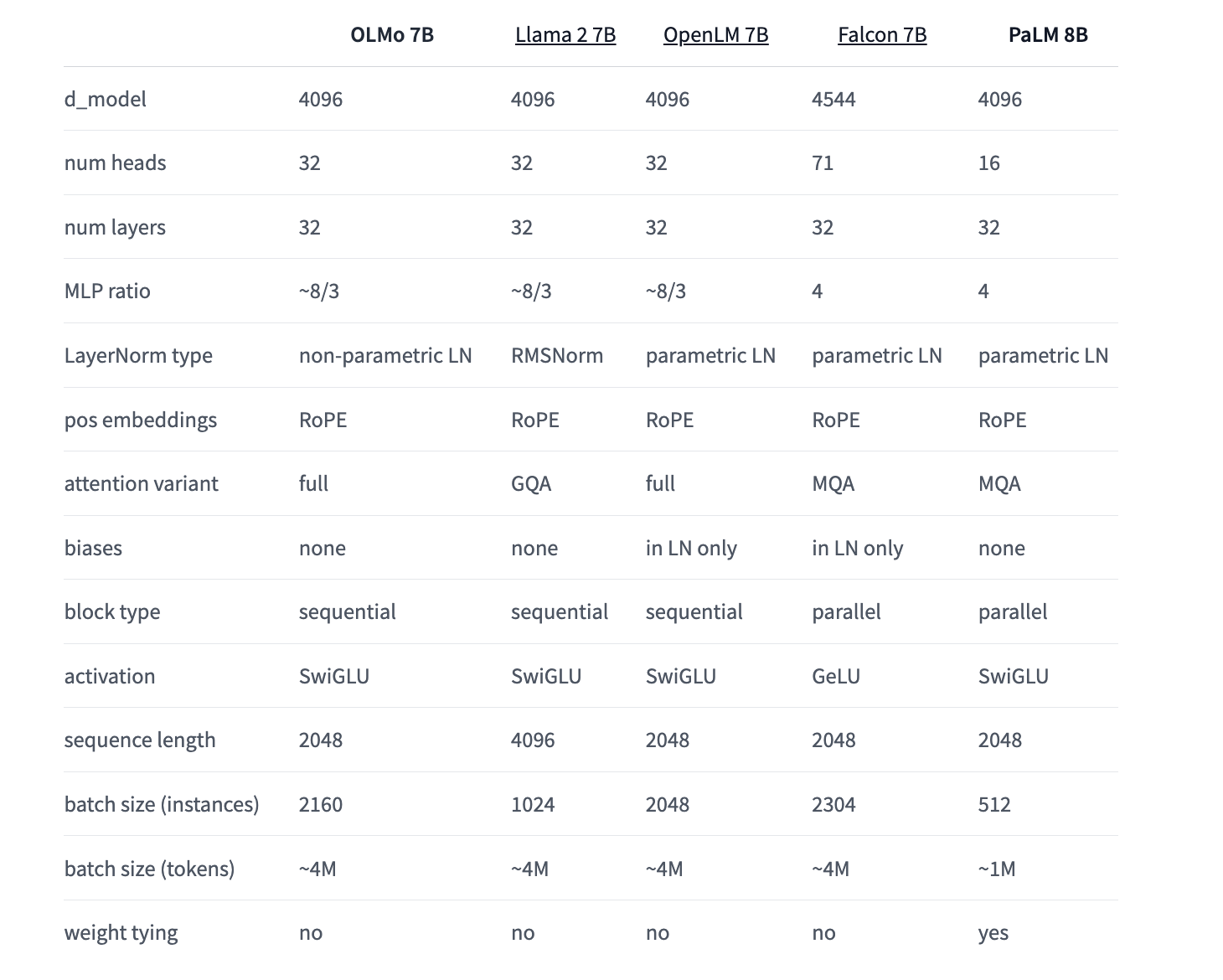

AI2 провела сравнительный анализ OLMo с другими открытыми и частично открытыми моделями, включая Pythia Suite от EleutherAI, модели MPT от MosaicML, модели Falcon от TII и серию Llama от Meta. Результаты оценки показывают, что OLMo 7B конкурентоспособен с популярными моделями, такими как Llama 2, демонстрируя сопоставимую производительность во многих задачах генерации и понимания текста, при этом немного уступая в некоторых задачах вопросно-ответной системы.

AI2 реализовала структурированный процесс релиза для OLMo и связанных инструментов. Регулярные обновления и новые ресурсы объявляются через шаблонные релизные заметки, распространяемые в социальных сетях, на веб-сайте AI2 и через рассылку. Этот подход обеспечивает пользователям актуальную информацию о последних разработках в экосистеме OLMo, включая Dolma и другие связанные инструменты.

Релиз OLMo июля 2024 года принес значительные улучшения как для модели 1B, так и для модели 7B. OLMo 1B июля 2024 года показал увеличение производительности в HellaSwag на 4,4 пункта, благодаря улучшенной версии набора данных Dolma и поэтапному обучению. Аналогично, OLMo 7B июля 2024 года использовал новейший набор данных Dolma и двухэтапный учебный план, постоянно улучшая производительность на 2-3 пункта.

Ранние релизы, такие как OLMo 7B апреля 2024 года (ранее OLMo 7B 1.7), представили расширенную длину контекста с 2048 до 4096 токенов и обучение на наборе данных Dolma 1.7. Эта версия превзошла производительность Llama 2-7B в MMLU и приблизилась к производительности Llama 2-13B, даже превзойдя ее в GSM8K. Эти пошаговые улучшения демонстрируют приверженность AI2 постоянному совершенствованию фреймворка OLMo и моделей.

Релиз OLMo является лишь началом амбициозных планов AI2 по разработке открытых языковых моделей. В настоящее время ведется работа над различными размерами моделей, модальностями, наборами данных, мерами безопасности и оценками для семейства OLMo. AI2 стремится совместно создать лучшую в мире открытую языковую модель, приглашая сообщество искусственного интеллекта принять участие в этой инновационной инициативе.

В двух словах, AI2 запустила OLMo – открытую языковую модель, предоставляющую исследователям полный доступ к данным, коду и инструментам оценки. Первоначальный релиз включает модели с 7 миллиардами и 1 миллиардом параметров, обученные на более чем 2 трлн токенов. OLMo способствует совместным исследованиям в области искусственного интеллекта, предлагая ресурсы, такие как полные данные обучения, веса моделей и более 500 контрольных точек для каждой базовой модели. Сравнительный анализ показывает конкурентоспособную производительность OLMo 7B по сравнению с другими открытыми моделями. AI2 реализовала структурированный процесс релиза, и недавние обновления принесли значительные улучшения. Эта инициатива является началом амбициозных планов AI2 по совместному созданию лучшей в мире открытой языковой модели.

Подробности смотрите здесь. Вся благодарность за этот проект исследователям. Также, не забудьте подписаться на наш Twitter и присоединиться к нашей Telegram-группе и группе LinkedIn. Если вам нравится наша работа, вы полюбите нашу рассылку.

Не забудьте присоединиться к нашему сообществу Reddit.

Узнайте о предстоящих вебинарах по искусственному интеллекту здесь.

Arcee AI выпустила DistillKit: открытый и простой в использовании инструмент для трансформации обучения моделей для создания эффективных небольших языковых моделей

Пост Аллен Института по искусственному интеллекту (AI2) о новом наборе активов OLMo 1B и 7B появился сначала на MarkTechPost.

«`