«`html

Управление и оптимизация вызовов API к различным поставщикам крупных языковых моделей (LLM)

Управление и оптимизация вызовов API к различным поставщикам крупных языковых моделей (LLM) могут быть сложными, особенно при работе с различными форматами, ограничениями на частоту запросов и управлением затратами. Создание последовательных интерфейсов для различных платформ LLM часто является проблемой, что затрудняет оптимизацию операций, особенно в корпоративной среде, где эффективность и управление затратами имеют важное значение.

Существующие решения и введение LiteLLM

Существующие решения для управления вызовами LLM API обычно включают в себя ручную интеграцию различных API с их собственными форматами и структурами ответов. Некоторые платформы предлагают ограниченную поддержку резервных механизмов или единой системы ведения журналов, но эти инструменты часто лишены гибкости или масштабируемости для эффективного управления несколькими поставщиками.

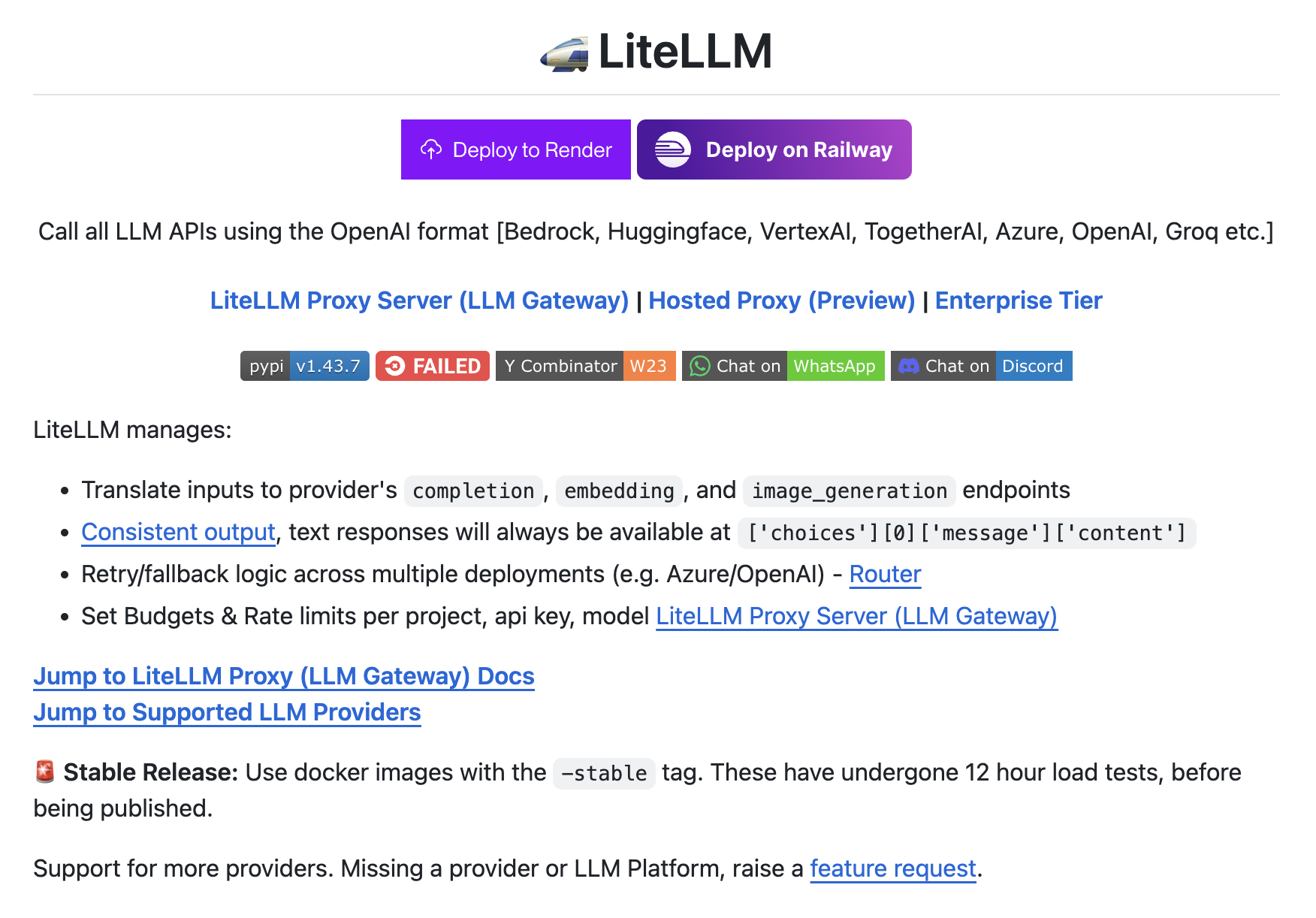

LiteLLM Proxy Server решает эти проблемы, предоставляя единый интерфейс для вызова LLM API с использованием одинакового формата независимо от поставщика. Он поддерживает широкий спектр поставщиков LLM, включая OpenAI, Huggingface, Azure и Google VertexAI, переводя входные и выходные данные в стандартный формат. Это упрощает процесс разработки, позволяя разработчикам переключаться между поставщиками без изменения основной логики их приложений. Кроме того, LiteLLM предлагает функции, такие как механизмы повторной попытки и резервирования, управление бюджетом и ограничениями частоты запросов, а также полное ведение журналов и наблюдаемость через интеграции с такими инструментами, как Lunary и Helicone.

Что касается производительности, LiteLLM демонстрирует надежные возможности с поддержкой как синхронных, так и асинхронных вызовов API, включая потоковые ответы. Платформа также позволяет балансировать нагрузку между несколькими развертываниями и предоставляет инструменты для отслеживания расходов и безопасного управления ключами API. Эти метрики и функции подчеркивают ее масштабируемость и эффективность, что делает ее подходящей для приложений корпоративного уровня, где управление несколькими поставщиками LLM является важным. Кроме того, ее способность интегрироваться с различными инструментами ведения журналов и мониторинга обеспечивает возможность разработчикам поддерживать видимость и контроль над использованием их API.

В заключение, LiteLLM предлагает комплексное решение для управления вызовами API с различными поставщиками LLM, упрощая процесс разработки и предоставляя необходимые инструменты для контроля затрат и наблюдаемости. Предлагая единый интерфейс и поддерживая широкий спектр функций, он помогает разработчикам оптимизировать свои рабочие процессы, уменьшить сложность и обеспечить эффективность и масштабируемость их приложений.

Использование LiteLLM для вашего бизнеса

Если вы хотите использовать искусственный интеллект (ИИ) в вашем бизнесе, LiteLLM предоставляет эффективное решение для управления вызовами API к различным поставщикам крупных языковых моделей (LLM). Он упрощает разработку, обеспечивает необходимые инструменты для контроля затрат и наблюдаемости, и помогает оптимизировать рабочие процессы.

Внедрение ИИ в ваш бизнес

Проанализируйте, как ИИ может изменить вашу работу и определите области, где автоматизация может быть применена, чтобы ваши клиенты могли извлечь выгоду из ИИ. Определите ключевые показатели эффективности (KPI), которые вы хотите улучшить с помощью ИИ, и постепенно внедряйте ИИ решения, начиная с малых проектов и расширяя их на основе полученных данных и опыта.

Получение консультаций по внедрению ИИ

Если вам нужны советы по внедрению ИИ, обращайтесь к нам на Telegram. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

AI Sales Bot

Попробуйте AI Sales Bot. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж и снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru. Будущее уже здесь!

«`