«`html

Разблокирование потенциала многомодальных языковых моделей (MLLMs) с помощью Uni-MoE: единая многомодальная LLM на основе разреженной архитектуры MoE

Разблокирование потенциала крупных многомодальных языковых моделей (MLLMs) для обработки различных модальностей, таких как речь, текст, изображение и видео, является ключевым этапом в развитии искусственного интеллекта. Эта способность необходима для приложений, таких как понимание естественного языка, рекомендация контента и многомодальный поиск информации, повышая точность и надежность систем ИИ.

Проблема и решение

Традиционные методы обработки многомодальных задач часто полагаются на плотные модели или подходы с одним экспертом по модальности. Плотные модели включают все параметры в каждом вычислении, что приводит к увеличению вычислительной нагрузки и ограничивает масштабируемость по мере увеличения размера модели. С другой стороны, подходы с одним экспертом лишены гибкости и адаптивности, необходимых для эффективной интеграции и понимания разнообразных многомодальных данных.

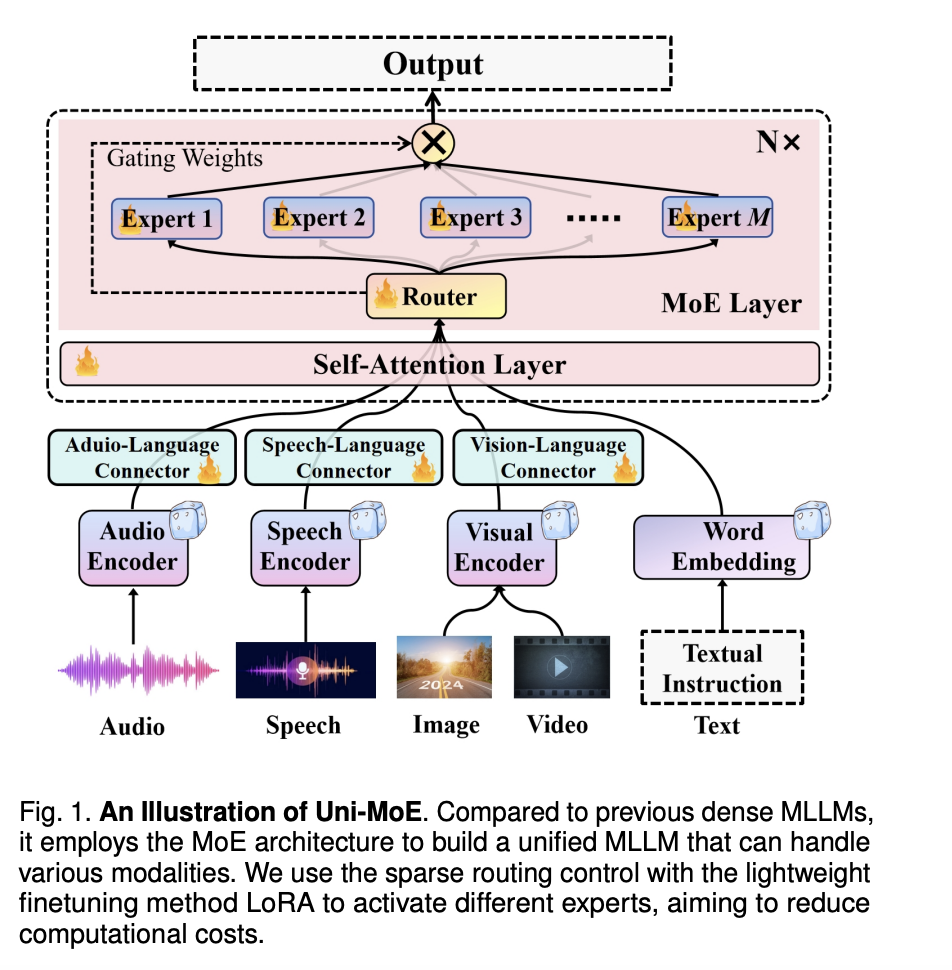

Исследователи из Харбинского института технологий предложили инновационный подход Uni-MoE, который использует архитектуру Mixture of Experts (MoE) вместе со стратегической трехфазной тренировочной стратегией. Uni-MoE оптимизирует выбор и сотрудничество экспертов, позволяя модально-специфическим экспертам синергетически улучшать производительность модели.

Технические преимущества Uni-MoE

Технические достижения Uni-MoE включают архитектуру MoE, специализирующуюся на различных модальностях, и трехфазовую тренировочную стратегию для оптимизированного сотрудничества. Продвинутые механизмы маршрутизации распределяют входные данные между соответствующими экспертами, оптимизируя вычислительные ресурсы.

Результаты

Результаты показывают превосходство Uni-MoE с точностью оценок от 62,76% до 66,46% по различным оценочным показателям, таким как ActivityNet-QA, RACE-Audio и A-OKVQA. Он превосходит плотные модели, демонстрирует лучшую обобщаемость и эффективно обрабатывает задачи понимания длинной речи.

Заключение

Uni-MoE представляет собой значительный прорыв в области многомодального обучения и систем ИИ. Его инновационный подход, использующий архитектуру Mixture of Experts (MoE) и стратегическую трехфазную тренировочную стратегию, решает ограничения традиционных методов и обеспечивает улучшенную производительность, эффективность и обобщаемость в различных модальностях.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж и снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru. Будущее уже здесь!

«`