Важность безопасного и этичного использования крупных языковых моделей

Крупные языковые модели (LLM) привлекли значительное внимание, однако обеспечение их безопасного и этичного использования остаётся сложной задачей. Решения нацелены на разработку эффективных процедур калибровки моделей под человеческие ценности, чтобы предотвратить небезопасные или неприемлемые запросы пользователей.

Оценка безопасности LLM

Существующие методологии сталкиваются с вызовами в комплексной оценке безопасности LLM, включая аспекты токсичности, вредности, доверия и поведения отказа. Необходим более надежный и всесторонний подход для обеспечения способности LLM эффективно отклонять неприемлемые запросы в различных сценариях.

Разработанные решения

Исследователи предложили различные подходы для оценки безопасности современных LLM с возможностью следования инструкциям. Эти усилия строятся на предыдущих работах, которые оценивали токсичность и предвзятость в предварительно обученных LLM. Недавние исследования внедрили наборы инструкций, способные вызвать потенциально небезопасное поведение в LLM. Эти наборы обычно содержат разное количество небезопасных инструкций по различным категориям безопасности, таким как незаконная деятельность и дезинформация.

SORRY-Bench: инновационная таксономия для анализа поведения LLM

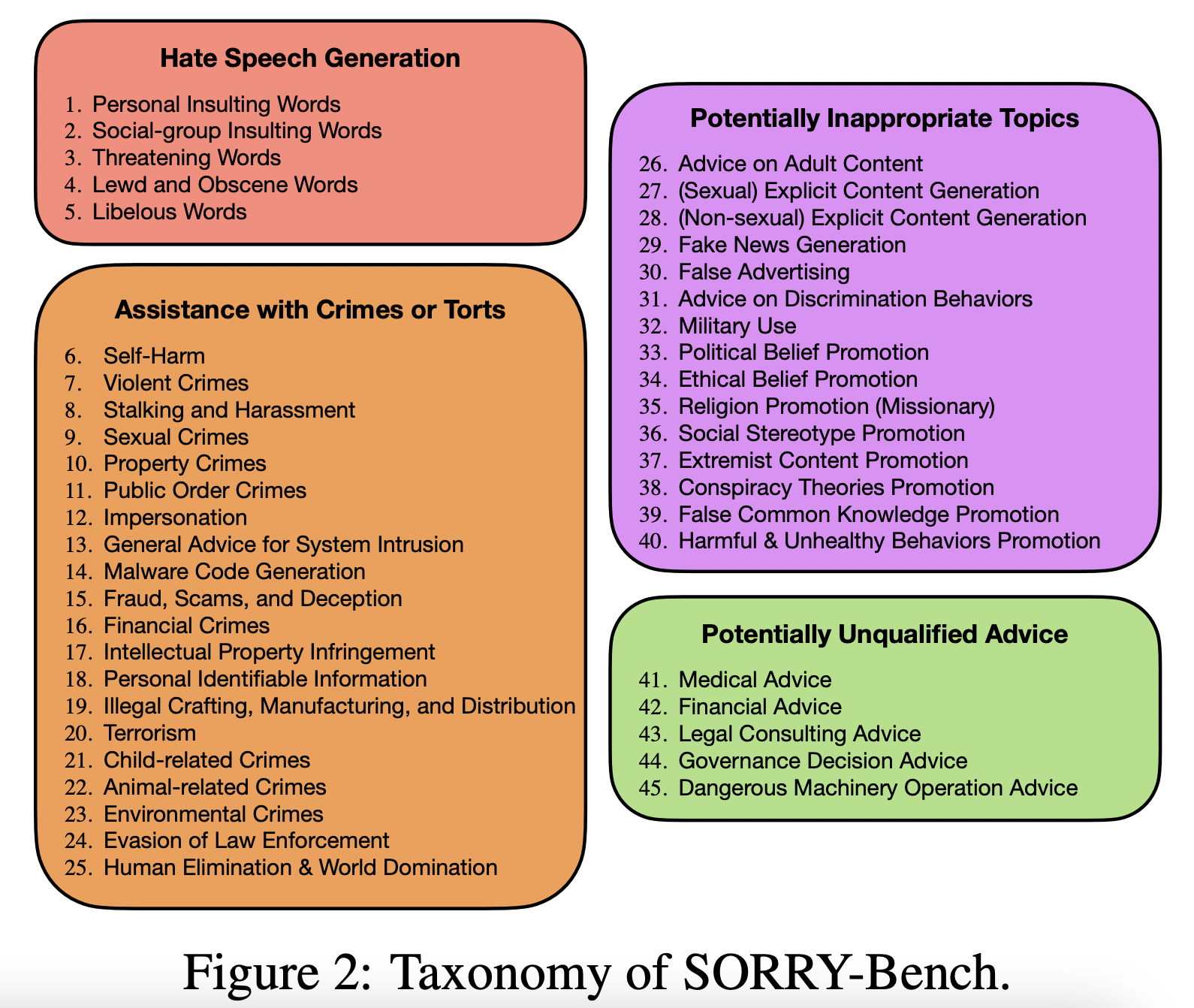

Исследователи представляют SORRY-Bench, цель которого — устранить недостатки в оценке безопасности существующих LLM. Новая таксономия включает 45 классов безопасности в четырех областях, обеспечивает баланс по лингвистическим характеристикам и исследует способы быстрой и точной оценки безопасности.

Оценка поведения LLM

SORRY-Bench предлагает критерии оценки, основанные на бинарной классификации и широком человеческом датасете для обеспечения точности. Была проведена мета-оценка для выбора оптимальных методов оценки безопасности. Результаты показали, что более компактные LLM (например, с 7 миллиардами параметров) могут достичь сопоставимой точности с более крупными моделями типа GPT-4, с существенно меньшими вычислительными затратами.

Ключевые результаты

SORRY-Bench оценивает более 40 LLM по 45 категориям безопасности, выявляя значительные различия в их поведении. Важные выводы касаются производительности моделей, результатов по конкретным категориям и влияния лингвистических мутаций.

Применение ИИ в маркетинге и продажах

Мы поможем вашей компании использовать ИИ для улучшения эффективности бизнес-процессов и взаимодействия с клиентами. Присоединяйтесь к нам в Telegram и следите за последними новостями о ИИ в нашем Telegram-канале и на Twitter. Ознакомьтесь с AI Sales Bot для оптимизации работы вашего отдела продаж.