«`html

Роль Red Teaming в оценке рисков ИИ

Red teaming играет важную роль в оценке рисков, связанных с моделями и системами ИИ. Он выявляет новые угрозы, находит недостатки в текущих мерах безопасности и усиливает количественные показатели безопасности. Это повышает общественное доверие и улучшает легитимность оценок рисков ИИ.

Подход OpenAI к внешнему Red Teaming

Эта работа описывает подход OpenAI к внешнему red teaming, подчеркивая его роль в оценке и снижении рисков в современных моделях ИИ. Сотрудничая с экспертами, OpenAI получает ценные данные о возможностях и уязвимостях моделей. Принципы, изложенные в документе, могут быть полезны другим организациям и заинтересованным сторонам.

Практическое значение Red Teaming

Внешний red teaming предлагает значительную ценность, выявляя критические аспекты оценки рисков ИИ. Он помогает обнаруживать новые риски и тестирует существующие защиты, улучшая безопасность систем. Интеграция доменной экспертизы улучшает оценки и создает независимые выводы, что способствует доверию.

Разнообразие методов Red Teaming

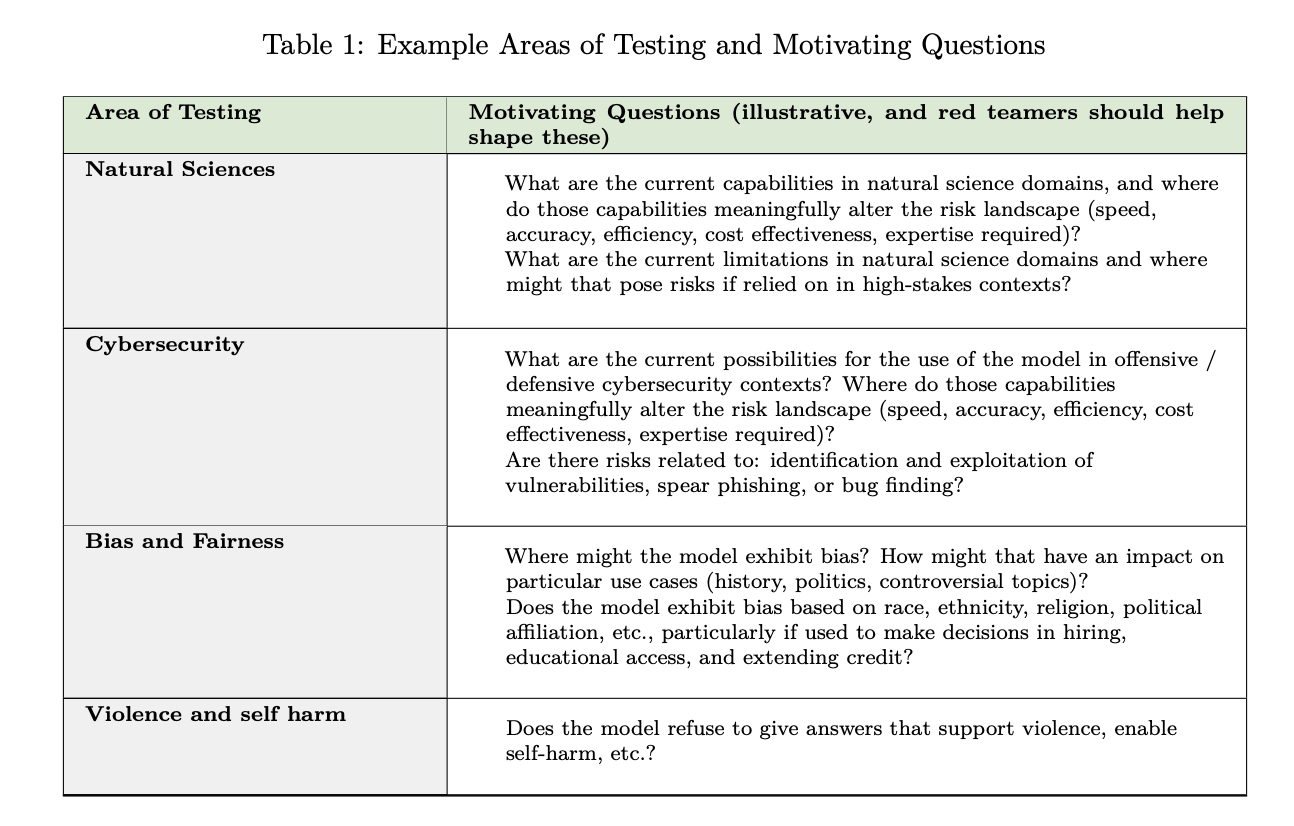

Практики red teaming варьируются в зависимости от сложности ИИ-систем. Методы могут включать ручные подходы, где эксперты создают противоречивые подсказки, а также автоматизированные, где ИИ генерирует подсказки и анализирует результаты. OpenAI применяет эти методы для оценки передовых моделей.

Процесс проектирования Red Teaming

Эффективная кампания red teaming требует стратегических решений и структурированных методик для оценки рисков ИИ. Ключевые шаги включают определение команды red teamers, формирование вопросов о модели и анализ полученных данных для создания всесторонних оценок.

Проблемы и ограничения Red Teaming

Хотя red teaming является ценным инструментом, существуют ограничения, такие как ресурсоемкость и потенциальные риски для участников. Также результаты могут терять актуальность с обновлениями моделей, что требует постоянной адаптации подходов.

Заключение

Red teaming, особенно при привлечении разнообразных экспертов, предоставляет проактивный механизм для выявления рисков. Однако необходима дополнительная работа для интеграции общественного мнения и установления мер ответственности. Red teaming вместе с другими практиками безопасности важен для создания эффективных оценок рисков ИИ.

Как интегрировать ИИ в вашу компанию

Если вы хотите, чтобы ваша компания развивалась с помощью ИИ, используйте red teaming для обеспечения безопасности и доверия.

- Анализируйте, как ИИ может изменить вашу работу и где можно применять автоматизацию.

- Определите ключевые показатели эффективности (KPI), которые хотите улучшить с помощью ИИ.

- Подбирайте подходящие решения и внедряйте их постепенно, начиная с небольших проектов.

- На основе полученных данных расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам. Следите за новостями об ИИ в нашем Телеграм-канале.

Попробуйте AI Sales Bot

Это AI ассистент для продаж, помогайте отвечать на вопросы клиентов и генерировать контент для отдела продаж. Узнайте, как ИИ может изменить процесс продаж в вашей компании!

«`