«`html

Решения для продаж и маркетинга: Применение искусственного интеллекта (ИИ) для улучшения бизнеса

Ключевым аспектом исследований в области ИИ является настройка больших языковых моделей (LLM) для соответствия предпочтениям человека. Эта настройка гарантирует, что системы ИИ генерируют полезные, актуальные и соответствующие ожиданиям пользователя ответы. Текущая парадигма в области ИИ подчеркивает важность обучения на основе данных о предпочтениях людей для улучшения этих моделей, решая сложности ручной спецификации функций вознаграждения для различных задач. Два основных метода в этой области — это онлайн обучение с подкреплением (RL) и офлайн контрастные методы, каждый из которых имеет уникальные преимущества и вызовы.

Проблема и практические решения

Одной из центральных проблем настройки LLM для отражения предпочтений людей является ограниченное покрытие статических наборов данных. Эти наборы данных должны адекватно представлять разнообразие и динамический спектр человеческих предпочтений в реальных приложениях. Проблема покрытия набора данных становится особенно острой, когда модели обучаются исключительно на предварительно собранных данных, что потенциально приводит к субоптимальной производительности. Это подчеркивает необходимость методов эффективного использования статических наборов данных и данных в реальном времени для улучшения соответствия модели предпочтениям людей.

Существующие техники для настройки предпочтений в LLM включают онлайн методы RL, такие как Proximal Policy Optimization (PPO), и офлайн контрастные методы, такие как Direct Preference Optimization (DPO). Онлайн методы RL включают двухэтапную процедуру, при которой модель вознаграждения обучается на фиксированном офлайн наборе предпочтений, за которым следует обучение RL с использованием данных в реальном времени. Этот подход позволяет получать обратную связь в реальном времени, но требует больших вычислительных ресурсов. В отличие от этого, офлайн контрастные методы оптимизируют политики исключительно на основе предварительно собранных данных, избегая необходимости выборки в реальном времени, но потенциально страдая от переобучения и ограниченных возможностей обобщения.

Новый метод HyPO: гибридная оптимизация предпочтений

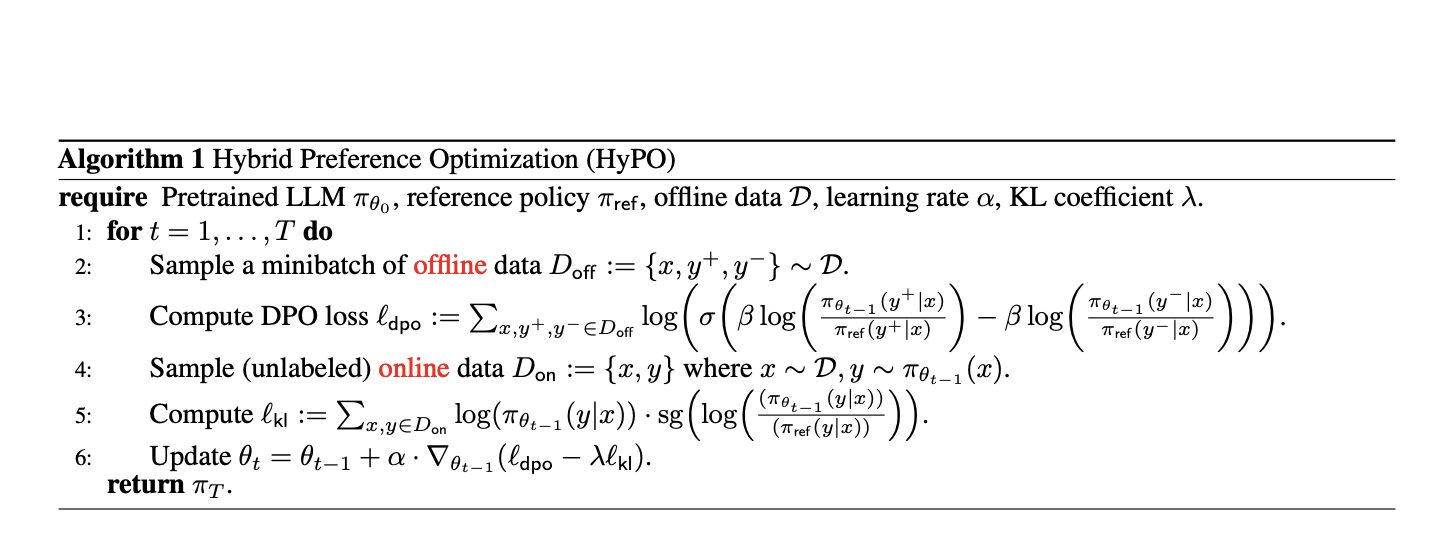

Исследователи из университетов Carnegie Mellon, Aurora Innovation и Cornell University представили новый метод под названием Hybrid Preference Optimization (HyPO). Этот гибридный подход объединяет мощь онлайн и офлайн техник с целью улучшения производительности модели при сохранении вычислительной эффективности. HyPO использует офлайн данные для начальной оптимизации предпочтений и онлайн неразмеченные данные для регуляризации Kullback-Leibler (KL), обеспечивая близость модели к эталонной политике и лучшее обобщение за пределами обучающих данных.

HyPO эффективно решает проблемы чисто офлайн методов, такие как переобучение и недостаточное покрытие набора данных, путем интеграции преимуществ онлайн методов RL без их вычислительной сложности.

Результаты и выводы

Результаты оценки производительности HyPO на нескольких бенчмарках, включая задачу TL;DR суммирования и общие бенчмарки чата, показали впечатляющие результаты. HyPO продемонстрировал значительное улучшение производительности по сравнению с DPO, подчеркивая потенциал для достижения более точных и надежных систем ИИ.

В заключение, внедрение гибридной оптимизации предпочтений (HyPO), которая эффективно сочетает офлайн и онлайн данные, решает ограничения существующих методов и улучшает соответствие больших языковых моделей предпочтениям людей. Улучшение производительности, продемонстрированное в эмпирических оценках, подчеркивает потенциал HyPO для достижения более точных и надежных систем ИИ.

Подробнее ознакомьтесь с исследованием. Все заслуги за это исследование принадлежат его авторам. Также не забудьте подписаться на наш Twitter и присоединиться к нашему каналу в Telegram и группе в LinkedIn. Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему сообществу Reddit

Найдите предстоящие вебинары по ИИ здесь

Этот пост был опубликован на MarkTechPost.

«`